mirror of

https://github.com/gelusus/wxvl.git

synced 2025-08-13 11:28:20 +00:00

src漏洞挖掘必备利器、前瞻对抗|这大概是首次,AI挖出了Linux内核可利用0day、朱雀实验室协助vLLM修复CVSS 9.8分严重漏洞、【漏洞预警】vLLM PyNcclPipe pickle反序列化漏洞(CVE-2025-47277)、

This commit is contained in:

parent

9b8acc57ef

commit

6972845526

@ -14370,5 +14370,9 @@

|

||||

"https://mp.weixin.qq.com/s?__biz=MzI4MDQ5MjY1Mg==&mid=2247516677&idx=1&sn=8bd54d9cb3ad82b65bcf77877a9bf7f4": "漏洞赏金工具 -- BBtool(5月21日更新)",

|

||||

"https://mp.weixin.qq.com/s?__biz=Mzg2MjgwMzIxMA==&mid=2247485153&idx=1&sn=df4a9596cf936fe6efbd34bb4cd75520": "JWT原理及常见漏洞详解",

|

||||

"https://mp.weixin.qq.com/s?__biz=Mzg2ODYxMzY3OQ==&mid=2247519372&idx=1&sn=50db0c7ee25f800969366f8c73e9e310": "PDF 生成器漏洞利用:查找 PDF 生成器中 SSRF 漏洞的完整指南",

|

||||

"https://mp.weixin.qq.com/s?__biz=MzkxNTIwNTkyNg==&mid=2247554886&idx=1&sn=b92b2a11c128532122d5ca74de178e49": "域0day容易利用吗"

|

||||

"https://mp.weixin.qq.com/s?__biz=MzkxNTIwNTkyNg==&mid=2247554886&idx=1&sn=b92b2a11c128532122d5ca74de178e49": "域0day容易利用吗",

|

||||

"https://mp.weixin.qq.com/s?__biz=MzIzMTIzNTM0MA==&mid=2247497634&idx=1&sn=0365b5a0a464632f064e7d4224b145b7": "src漏洞挖掘必备利器",

|

||||

"https://mp.weixin.qq.com/s?__biz=MzkyMjM5MTk3NQ==&mid=2247488640&idx=1&sn=41e022b30064dc14da381bd803fe3c13": "前瞻对抗|这大概是首次,AI挖出了Linux内核可利用0day",

|

||||

"https://mp.weixin.qq.com/s?__biz=MjM5NzE1NjA0MQ==&mid=2651207157&idx=1&sn=7756328ed7d6b73c0e9d042ccf620f64": "朱雀实验室协助vLLM修复CVSS 9.8分严重漏洞",

|

||||

"https://mp.weixin.qq.com/s?__biz=MzkwMDc1MTM5Ng==&mid=2247484085&idx=1&sn=e447afc95940697dfe60767d5170f6ad": "【漏洞预警】vLLM PyNcclPipe pickle反序列化漏洞(CVE-2025-47277)"

|

||||

}

|

||||

41

doc/2025-05/src漏洞挖掘必备利器.md

Normal file

41

doc/2025-05/src漏洞挖掘必备利器.md

Normal file

@ -0,0 +1,41 @@

|

||||

# src漏洞挖掘必备利器

|

||||

迪哥讲事 2025-05-22 00:31

|

||||

|

||||

推荐以下几个公众号,挖掘src时必备,不仅内容丰富,而且干货满满!长期更新高质量文章,同时还涉及红蓝对抗、内外网渗透、代码审计、APP 安全测试、应急响应、漏洞挖掘、常用安全工具等,你想要的内容这里都有!以下排名不分先后顺序。

|

||||

## 银遁安全团队

|

||||

|

||||

网安吃瓜哪家强?欢迎关注,不定时分享网络安全领域各种资源,学习文档,以及工具分享、前沿信息分享,一起来玩儿啊~

|

||||

|

||||

|

||||

## 泷羽Sec

|

||||

|

||||

从零开始学网安,专注于网络安全领域的创作与分享,包括且不限于渗透测试,内网渗透,免杀,红蓝攻防,安全工具分享等,为网络安全而战。

|

||||

|

||||

|

||||

## Z2O安全攻防

|

||||

|

||||

From Zero To One. 致力于红蓝对抗、实战攻防、SRC赏金 涉及方向包括Web渗透、免杀绕过、内网攻防、代码审计、应急响应、云安全等各个方向。

|

||||

|

||||

|

||||

## 夜组安全

|

||||

|

||||

"恐惧就是貌似真实的伪证" NightCrawler Team(简称:夜组)主攻WEB安全 | 内网渗透 | 红蓝对抗 | 代码审计 | APT攻击,致力于将每一位藏在暗处的白帽子聚集在一起,在夜空中划出一道绚丽的光线!

|

||||

|

||||

|

||||

## 网络安全实验室

|

||||

|

||||

专注于网络安全领域,包括安全岗位招聘、红蓝队建设、实战攻防、内网渗透、社工、CTF比赛、安全技术分享等。

|

||||

|

||||

|

||||

## 菜鸟学信安

|

||||

|

||||

web安全入门、进阶技巧,红蓝攻防、应急响应、内网渗透、漏洞分析等技术文章分享,以及网络安全工具、视频教程及学习资料。

|

||||

|

||||

|

||||

## 渗透Xiao白帽

|

||||

|

||||

热衷于研究安全攻防,本着“相互学习,共同进步”的原则。致力于分享内网渗透、远控免杀、APP安全测试和常用安全工具类的技术分享,包括分享一些奇淫巧技的思路!

|

||||

|

||||

|

||||

|

||||

|

||||

@ -0,0 +1,62 @@

|

||||

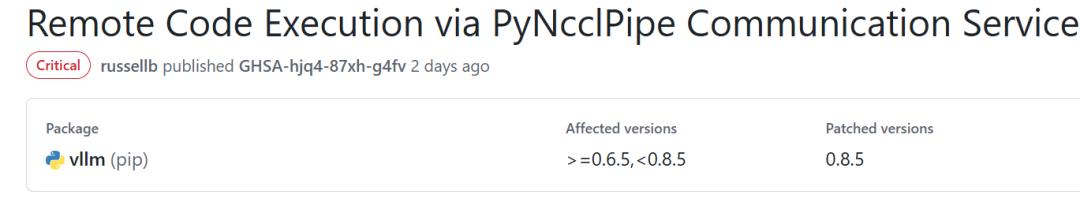

# 【漏洞预警】vLLM PyNcclPipe pickle反序列化漏洞(CVE-2025-47277)

|

||||

原创 安全探索者 安全探索者 2025-05-22 09:05

|

||||

|

||||

点击关注,获取更多漏洞预警,技术分享

|

||||

|

||||

0x01 组件介绍

|

||||

|

||||

vLLM是一个专为大型语言模型(LLM)推理设计的高性能框架,通过创新的内存管理和计算加速技术,显著提升吞吐量并降低延迟,特别适用于企业级高并发场景。目前,有众多企业广泛使用vLLM进行AI模型推理,其安全性直接关系到AI服务的稳定性和数据安全。

|

||||

|

||||

|

||||

0x02 漏洞描述

|

||||

|

||||

|

||||

|

||||

CVE-2025-47277中,当 vllm 使用`PyNcclPipe` KV缓存传输集成与V0引擎的环境时,由于 PyNcclPipe 存在一个pickle反序列化漏洞,当PyNcclPipe组件对外暴露时,未经授权的远程攻击者可以连接到该组件,并发送恶意序列化数据,执行任意代码,可能导致服务器失陷。

|

||||

|

||||

|

||||

|

||||

<table><tbody><tr><td data-colwidth="143" width="143" style="border-color:#0080ff;"><section><span leaf="">漏洞分类</span></section></td><td colspan="3" data-colwidth="143,143,143" width="143,143,143" style="border-color:#0080ff;"><section><span leaf="">反序列化</span></section></td></tr><tr><td data-colwidth="143" width="143" style="border-color:#0080ff;"><section><span leaf="" data-pm-slice="1 1 ["table",{"interlaced":null,"align":null,"class":null,"style":null},"table_body",{},"table_row",{"class":null,"style":null},"table_cell",{"colspan":1,"rowspan":1,"colwidth":[143],"width":null,"valign":null,"align":null,"style":null},"para",null]">CVSS 3.1分数</span></section></td><td data-colwidth="143" width="143" style="border-color:#0080ff;"><section><span leaf=""><span textstyle="" style="color: rgb(255, 0, 0);">9.8</span></span></section></td><td data-colwidth="143" width="143" style="border-color:#0080ff;"><section><span leaf="">漏洞等级</span></section></td><td data-colwidth="143" width="143" style="border-color:#0080ff;"><section><span leaf=""><span textstyle="" style="color: rgb(255, 0, 0);">严重</span></span></section></td></tr><tr><td data-colwidth="143" width="143" style="border-color:#0080ff;"><section><span leaf="">POC/EXP</span></section></td><td data-colwidth="143" width="143" style="border-color:#0080ff;"><section><span leaf=""> </span><span leaf=""><span textstyle="" style="color: rgb(255, 0, 0);">未公开</span></span></section></td><td data-colwidth="143" width="143" style="border-color:#0080ff;"><section><span leaf="">可利用性</span></section></td><td data-colwidth="143" width="143" style="border-color:#0080ff;"><section><span leaf=""><span textstyle="" style="color: rgb(255, 0, 0);">未知</span></span></section></td></tr></tbody></table>

|

||||

|

||||

0x03 影响版本

|

||||

|

||||

0.6.5 <= vLLM < 0.8.5

|

||||

<table><tbody><tr style="-webkit-tap-highlight-color: transparent;outline: 0px;visibility: visible;"></tr></tbody></table>

|

||||

|

||||

0x04 漏洞验证

|

||||

|

||||

目前POC/EXP尚未公开

|

||||

|

||||

但官方有演示利用的过程,可参考一下

|

||||

|

||||

|

||||

|

||||

|

||||

0x05 漏洞影响

|

||||

|

||||

由于该漏洞影响范围较广,危害较大。通过官方复现过程,我们可以知道该漏洞的利用过程比较简单,且能造成的危害是严重的,可以获取系统权限。企业应该尽快排查是否有使用该组件,并尽快做出对应措施

|

||||

|

||||

|

||||

0x06 修复建议

|

||||

|

||||

官方已发布修复方案,受影响的用户建议及时更新至安全版本0.8.5。

|

||||

|

||||

官方链接:

|

||||

|

||||

https://github.com/vllm-project/vllm/releases

|

||||

|

||||

0X07 参考链接

|

||||

|

||||

https://github.com/vllm-project/vllm/security/advisories/GHSA-hjq4-87xh-g4fv

|

||||

|

||||

|

||||

0x08 免责声明

|

||||

|

||||

> 本文所涉及的任何技术、信息或工具,仅供学习和参考之用。

|

||||

|

||||

> 请勿利用本文提供的信息从事任何违法活动或不当行为。任何因使用本文所提供的信息或工具而导致的损失、后果或不良影响,均由使用者个人承担责任,与本文作者无关。

|

||||

|

||||

> 作者不对任何因使用本文信息或工具而产生的损失或后果承担任何责任。使用本文所提供的信息或工具即视为同意本免责声明,并承诺遵守相关法律法规和道德规范。

|

||||

|

||||

|

||||

|

||||

175

doc/2025-05/前瞻对抗|这大概是首次,AI挖出了Linux内核可利用0day.md

Normal file

175

doc/2025-05/前瞻对抗|这大概是首次,AI挖出了Linux内核可利用0day.md

Normal file

@ -0,0 +1,175 @@

|

||||

# 前瞻对抗|这大概是首次,AI挖出了Linux内核可利用0day

|

||||

原创 前瞻对抗 DARKNAVY 2025-05-22 07:01

|

||||

|

||||

|

||||

|

||||

正如 DARKNAVY 在**深蓝洞察 | 2024年度最具想象空间的新应用**

|

||||

所展望的:

|

||||

> **新一代的 AI Agent 将具备优秀的推理能力和泛化能力,并能熟练地运用多种安全研究工具,继承大量的人类专家经验,如同顶尖的安全专家一般,发现现实世界中更多的 0day 漏洞。**

|

||||

|

||||

|

||||

不出所料,随着大语言模型 (LLM) 对复杂任务处理能力的日益增强,**智能体技术**

|

||||

(Agent) 正在成为漏洞挖掘领域的新型范式。随着去年 Google Project Zero 团队推出了 Naptime[1]

|

||||

,越来越多的 Agent 审计工具正在涌现,通过为 LLM 提供必要的工具集和待测源码,模拟安全研究员的行为进行代码审计与漏洞确认。

|

||||

|

||||

然而,DARKNAVY 观察到单个 Agent 在审计中大型项目时,常因 LLM 推理能力的**局限性**

|

||||

(如逻辑不完整、幻觉现象)导致误报与漏报。DARKNAVY 基于多年实际漏洞挖掘经验,提出了 multi-agent 系统架构,通过模拟安全团队内部的分工与协作机制,实现了**全自动漏洞挖掘工具 Argusee**

|

||||

。

|

||||

|

||||

在对 Linux USB 协议栈源码的测试中,Argusee 在短时间内便发现了一个自 Linux 6.5 版本引入的高危漏洞,该漏洞已获编号 **CVE-2025-37891**

|

||||

并得到修复,影响了包括 Ubuntu 和 Arch Linux 在内的多个主流发行版。DARKNAVY 对该漏洞进行利用开发后得到了一个在 Arch Linux 上稳定提升至 root 权限的利用脚本:

|

||||

|

||||

|

||||

本篇为《深蓝洞察》系列最新技术专栏

|

||||

「前瞻对抗」

|

||||

的首篇。

|

||||

|

||||

|

||||

**Argusee:多智能体协同架构**

|

||||

|

||||

> **Argus had a hundred eyes round his head, that took their rest two at a time in succession while the others kept watch and stayed on guard.**

|

||||

> — Ovid: The Metamorphoses

|

||||

|

||||

|

||||

尽管 Naptime 等单 Agent 工具为 LLM 驱动的代码审计提供了可用范式,但在面对中大型项目时,往往因模型推理逻辑不够严谨、上下文感知有限而产生较多误报与漏报,且难以灵活调整审计流程,难以满足对精准定位和深度验证的需求。

|

||||

|

||||

对此,Argusee **并非旨在完全取代人工审计,进行从零开始的漏洞挖掘**

|

||||

,而是作为安全审计人员强大的辅助工具,依赖于审计人员提供精确的分析入口(如特定的函数或代码模块)及必要的上下文信息,在此基础上进行深度分析与潜在风险识别,从而大幅提升专业审计人员的工作效率。

|

||||

|

||||

与现有工作不同,Argusee 的核心创新在于其**多智能体协同机制**

|

||||

,其借鉴了人类安全团队的协作模式,将复杂的审计任务分解给不同角色的智能体。更重要的是,相较于一些早期多智能体探索[2]

|

||||

中各智能体功能相对独立、交互固化的方式,Argusee 赋予了 LLM 更大的自主权,使其能够动态地进行任务理解与分派,从而实现更灵活和高效的协同审计。这正对应了

|

||||

强化学习之父

|

||||

Richard Sutton 在 **The Bitter Lesson**

|

||||

一文中所写到的:「我们**希望人工智能 Agent 能够像我们人类一样去发现**

|

||||

,而不是在系统里集成我们已经发现的东西。建立在我们已知发现之上只会让我们更难看到如何完成发现过程。」

|

||||

|

||||

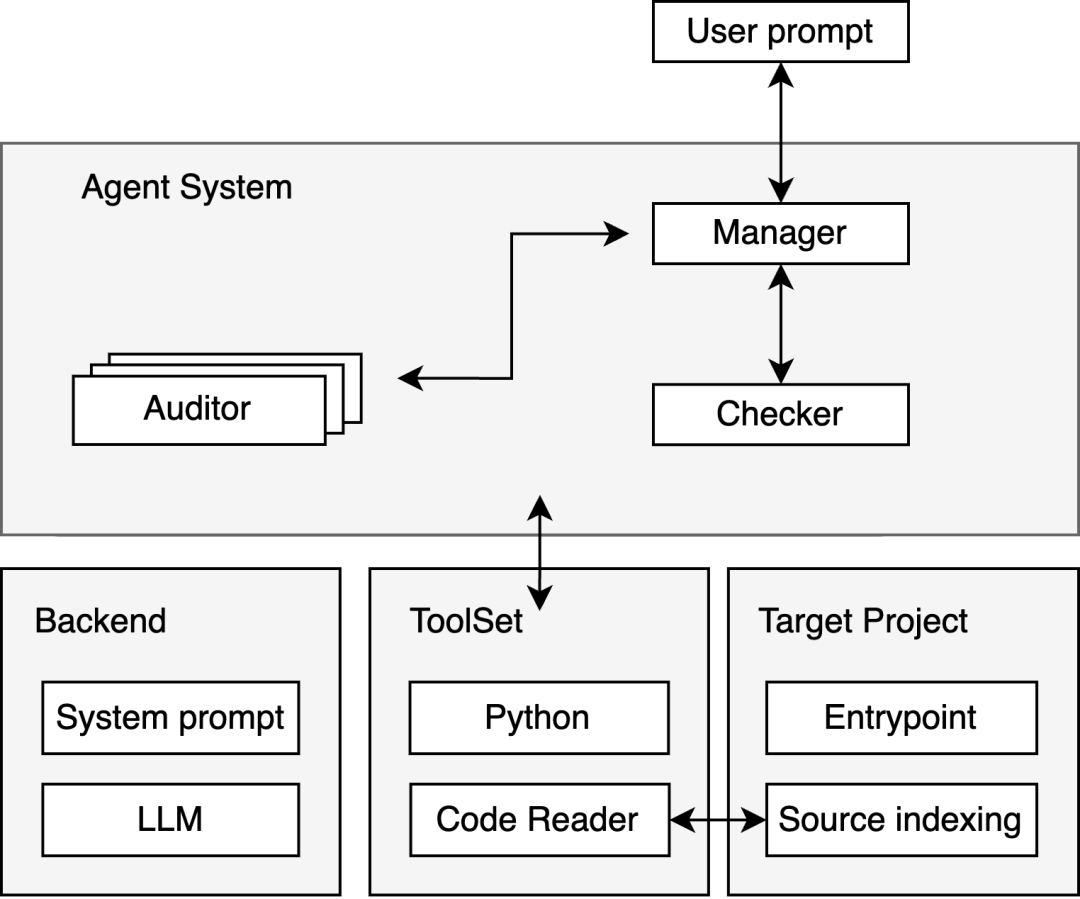

作为一个实现原型,Argusee 的架构如下图所示,主要包含以下核心智能体:

|

||||

|

||||

|

||||

|

||||

Argusee 原型框架图

|

||||

1. **管理者 Manager Agent**

|

||||

|

||||

Manager 是用户的交互点,用户向其提供分析入口(如目标文件或函数)。Manager 负责从宏观层面理解任务,例如,判断函数核心功能,识别潜在的关键代码段,并进行任务分解与分派,将不同的代码片段连同必要的上下文信息分发给多个 Auditor。

|

||||

|

||||

1. **审计员 Auditor Agent**

|

||||

|

||||

Auditor 专注于分析来自 Manager 分配的、通常较为短小的代码片段。它们结合上下文信息,深入挖掘代码细节中可能存在的漏洞,如 Buffer Overflow,Use After Free 等漏洞。

|

||||

|

||||

1. **校验者 Checker Agent**

|

||||

|

||||

为了降低误报和漏报,Manager 在汇总审计结果并输出最终结论前,会请求 Checker 对整个逻辑链条进行复核与验证,查漏补缺。最终,由 Manager 整合信息并输出审计报告。

|

||||

|

||||

各 Agent 在执行任务过程中,均可按需调用预设的工具集,工具的使用时机和方式皆由 Agent 自主决策。另一方面,后端工具集的有效运行依赖于对目标项目和环境的适配,例如,源码阅读器 (Code Reader) 的变量定位功能依赖于后端语言服务协议 (LSP) 所建立的源码索引功能。

|

||||

|

||||

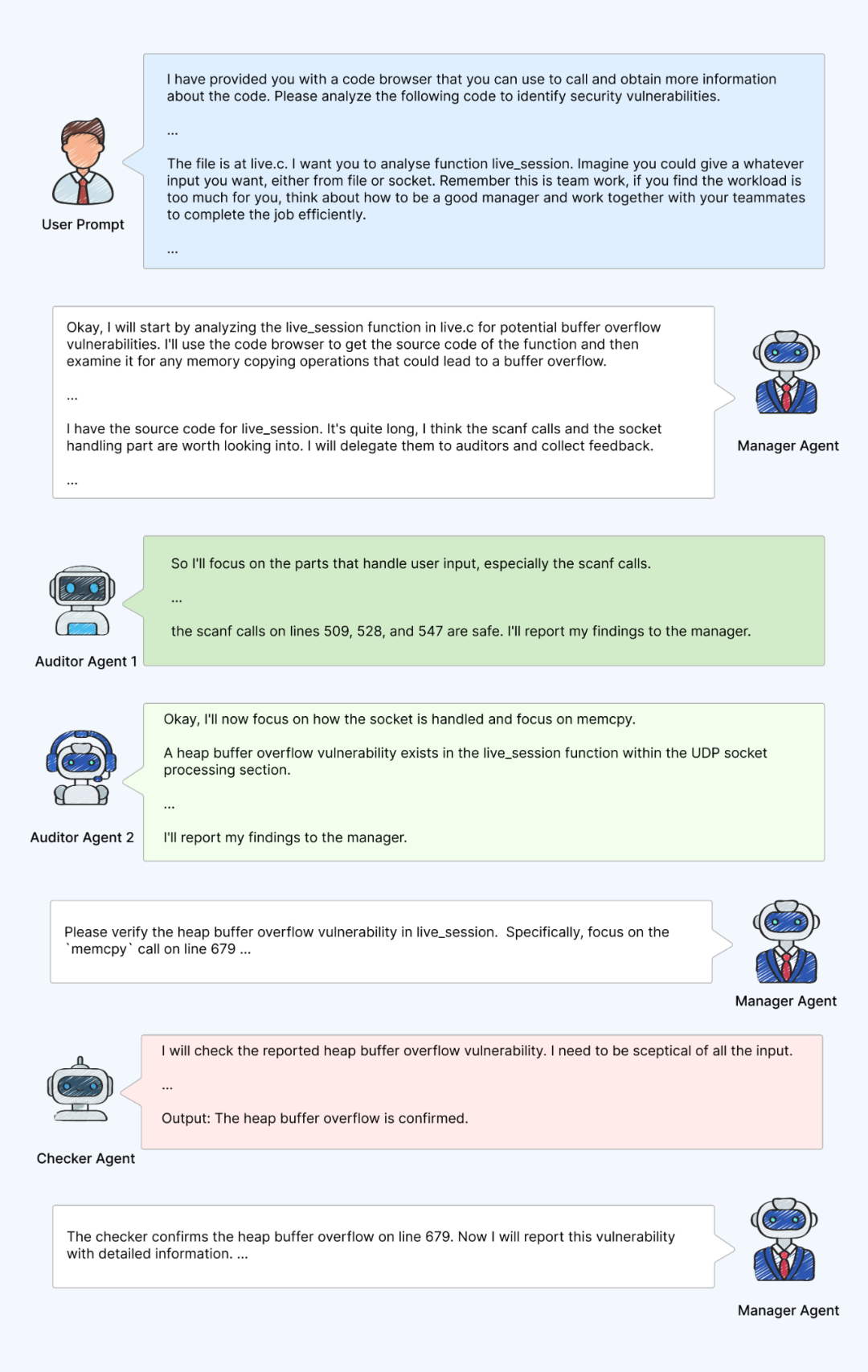

为了更好的理解 Argusee 的工作流程,下图展示了 Argusee 在实际运行过程中的思维链条:

|

||||

|

||||

|

||||

|

||||

Argusee 在某次实际运行时的简化工作流程

|

||||

|

||||

用户在指定目标文件和入口函数的情况下,Manager 通过分析将任务分派给了两个 Auditor,其中一个 Auditor 发现了一处疑似缓冲区溢出风险并报告给了 Manager。随后,Manager 请求 Checker 对该漏洞进行了复核,最终确认这是一处真实存在的堆缓冲区溢出漏洞,并产出了漏洞审计报告。

|

||||

|

||||

|

||||

**实战测试与效果评估**

|

||||

|

||||

|

||||

为验证 Argusee 的有效性,我们分别在基准测试数据、中小规模开源项目和超大规模开源项目(如 Linux 内核)上对其进行了测试评估。

|

||||

|

||||

**基准数据集测试**

|

||||

|

||||

|

||||

在来自 META CyberSecEval 2[3]

|

||||

的单文件标准测试用例中,Argusee 展现出接近完美的漏洞识别能力,在 Buffer Overflow 等类别的测试用例上达到了 **100% 的准确率**

|

||||

。

|

||||

|

||||

**中小规模开源项目实战审计**

|

||||

|

||||

针对中等规模的真实世界开源项目,Argusee 同样取得了显著成果,**在多个经过充分测试的项目中累计发现了 15 个先前未知的安全缺陷**

|

||||

,测试项目涉及到 GPAC、GIFLIB 等多个解析复杂文件格式的开源软件库。

|

||||

|

||||

以开源多媒体框架 GPAC[4]

|

||||

为例,该项目长期经受 Fuzz 测试,近年来被发现的新漏洞相对较少。然而,**Argusee 在短时间内便识别出数个较难通过传统方式发现的新漏洞**

|

||||

。DARKNAVY 观察到,对于 GPAC 这类输入格式明确、以内容解析为核心功能的目标,Argusee 的表现尤为突出。

|

||||

|

||||

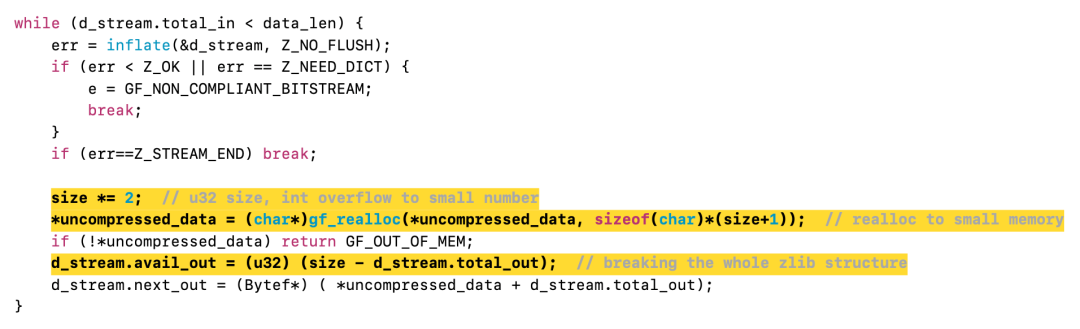

例如,下图代码是 Augusee 发现的一处**整数溢出**

|

||||

造成的**内存破坏漏洞**

|

||||

。对于 Fuzzer 而言,要构造出能够触发此漏洞(需满足 zlib 压缩格式且原始数据足够大以引发溢出)的输入样本难度极高。而 Argusee 通过模拟人工审计的逻辑推理过程,成功定位了这一深藏的缺陷。

|

||||

|

||||

|

||||

|

||||

Argusee 在 GPAC 中发现的内存破坏漏洞代码

|

||||

|

||||

|

||||

**Linux Kernel 实战审计**

|

||||

|

||||

|

||||

除此之外,Argusee 也针对体量庞大的代码项目进行了尝试,例如 **Linux Kernel USB 协议栈**

|

||||

这类庞大且复杂的项目。在使用过程中,尽管需要为 Agent 提供更丰富的上下文信息,Argusee 在代码的辅助理解、高风险区域定位等方面依然表现出强大的潜力,能够显著提升研究人员的审计效率。

|

||||

|

||||

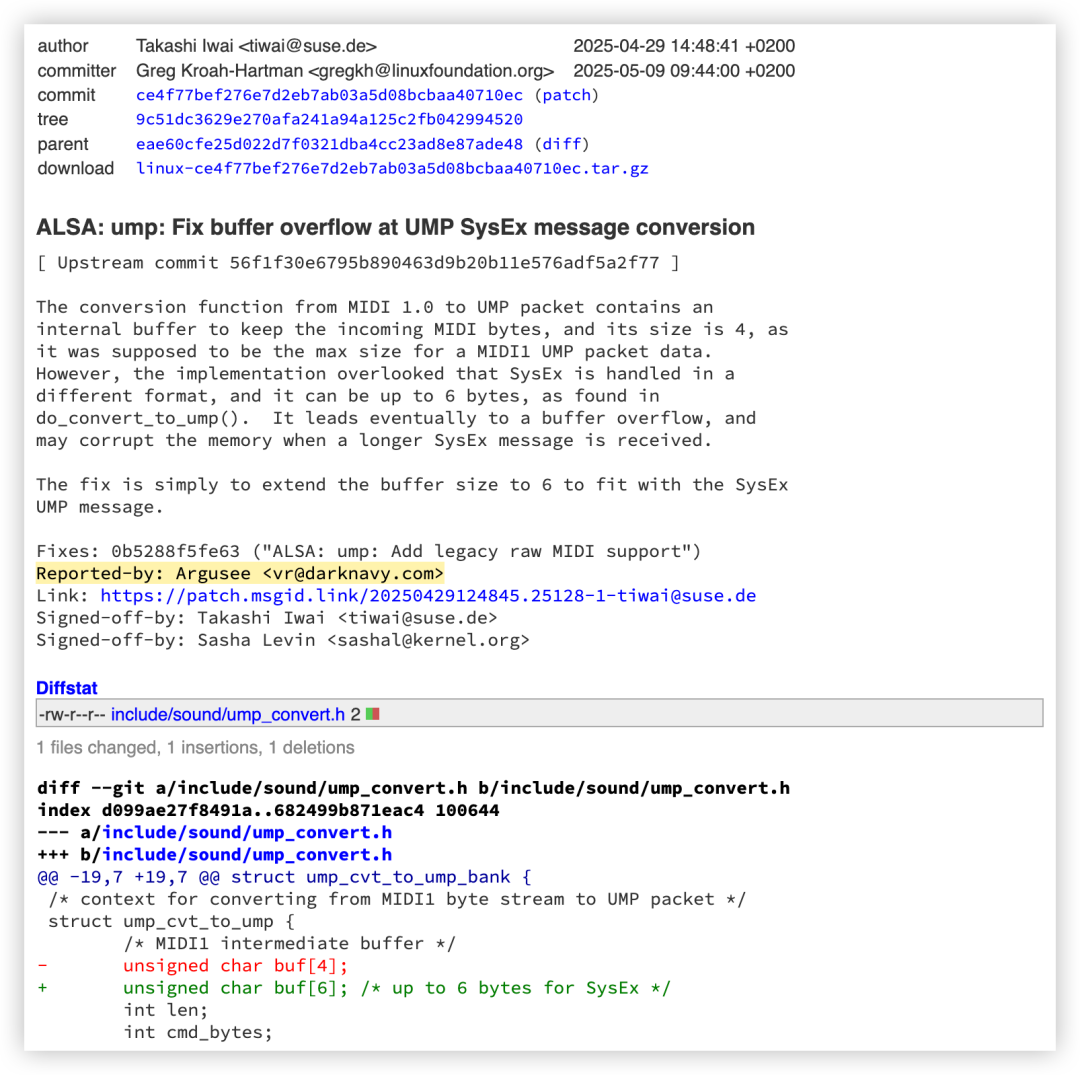

下图为 Argusee 在 Linux Kernel USB 协议栈中找到的漏洞 CVE-2025-37891[5]

|

||||

:

|

||||

|

||||

|

||||

|

||||

CVE-2025-37891 的修复补丁

|

||||

|

||||

该漏洞发生在 Linux 内核 USB 的主机侧,恶意用户可以通过插入支持 USB MIDI2 协议的模拟设备来进行攻击。对于支持 MIDI2 的 USB 设备,Linux 内部会将 MIDI1 包转换成 UMP 包,

|

||||

由于长度检测不当,转换时用来存储 MIDI 字节流的缓冲区可以发生溢出

|

||||

,使得攻击者获得内核堆上任意溢出的原语。Augusee 被指定 USB MIDI2 入口点相关函数与文件后,迅速找到了此漏洞并提供了清晰的漏洞原理分析与复现。

|

||||

|

||||

当然,Argusee 的能力不止于此。鉴于构建全面的漏洞挖掘能力评估数据集及衡量标准本身是一项复杂工作,更细致的量化评估以及实战测试结果将在后续的研究中呈现。

|

||||

|

||||

展望未来,为了进一步释放 Argusee 的潜力,基于当前原型,Argusee 还可以围绕以下三个维度进行增强补充:

|

||||

- Agent 系统

|

||||

:引入更多专业角色,如负责构造 PoC 以验证漏洞的复现者 (Reproducer Agent),以及评估漏洞可利用性并尝试编写 Exploit 的利用者 (Exploit Agent)。

|

||||

|

||||

- 工具集

|

||||

:集成更丰富的分析工具,如调试器,帮助 Agent 理解程序执行流和漏洞触发过程,以及其他高级静态、动态分析工具等,构建强大的武器库。

|

||||

|

||||

- 目标项目与环境

|

||||

:整合更多辅助代码审计的信息源,如利用 RAG 技术检索相关源码知识、分析编译后的二进制文件等。

|

||||

|

||||

|

||||

**结语**

|

||||

|

||||

|

||||

|

||||

智能体技术正深刻变革漏洞挖掘的既有范式,而 Argusee 的实践证明,多智能体协同是提升代码审计效率的有效途径。赋予 LLM 合适的结构与工具,结合人类研究员的经验,更高效地自动化发现漏洞,其潜力远超单体智能的局限。

|

||||

|

||||

此趋势下的探索,Argusee 仅是起点。DARKNAVY 致力于深化智能体协同安全研究,让 AI 智能体与安全专家无缝协作、各展所长,共同构筑稳固的数字防线。

|

||||

|

||||

或许某一天,在这场智能体引领的变革中,安全人员将从繁重的低级审计工作中解放,更多聚焦策略设计与风险评估;当经验与创见得以释放时,又能推动安全研究达到怎样的新高度?

|

||||

|

||||

|

||||

**参 考:**

|

||||

|

||||

[1] https://googleprojectzero.blogspot.com/2024/06/project-naptime.html

|

||||

|

||||

[2] https://arxiv.org/html/2409.00899v2

|

||||

|

||||

[3] https://arxiv.org/abs/2404.13161

|

||||

|

||||

[4] https://github.com/gpac/gpac

|

||||

|

||||

[5] https://git.kernel.org/stable/c/ce4f77bef276e7d2eb7ab03a5d08bcbaa40710ec

|

||||

|

||||

|

||||

预告

|

||||

|

||||

|

||||

|

||||

AI会有一天取代白帽黑客吗?

|

||||

6月16日,专注纯粹技术交流的全新网络安全闭门沙龙 deepsec.cc (

|

||||

Deep Sec

|

||||

urity

|

||||

C

|

||||

losed-door

|

||||

C

|

||||

onference),

|

||||

DARKNAVY 将

|

||||

在现场继续深入探讨 Argusee:

|

||||

|

||||

[](https://mp.weixin.qq.com/s?__biz=MzkzODk5NjMwNw==&mid=2247483795&idx=1&sn=bf33127ed60daca7a00d0603c51b7c74&scene=21#wechat_redirect)

|

||||

|

||||

97

doc/2025-05/朱雀实验室协助vLLM修复CVSS 9.8分严重漏洞.md

Normal file

97

doc/2025-05/朱雀实验室协助vLLM修复CVSS 9.8分严重漏洞.md

Normal file

@ -0,0 +1,97 @@

|

||||

# 朱雀实验室协助vLLM修复CVSS 9.8分严重漏洞

|

||||

原创 腾讯朱雀实验室 腾讯安全应急响应中心 2025-05-22 03:24

|

||||

|

||||

> 作者:Kikay、Nicky

|

||||

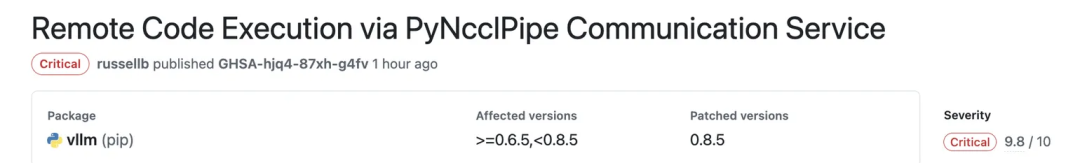

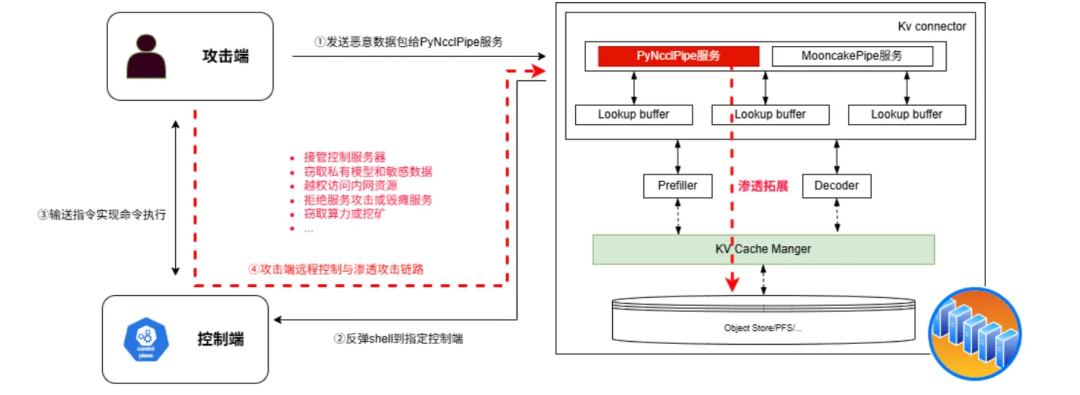

> 腾讯朱雀实验室发现vLLM推理框架存在严重安全漏洞(CVE-2025-47277,CVSS 9.8分),攻击者可利用此漏洞控制GPU服务器,窃取模型、算力或中断服务。vLLM团队已修复该漏洞并致谢腾讯朱雀实验室。

|

||||

|

||||

|

||||

|

||||

1. vLLM框架的重要性与安全挑战

|

||||

|

||||

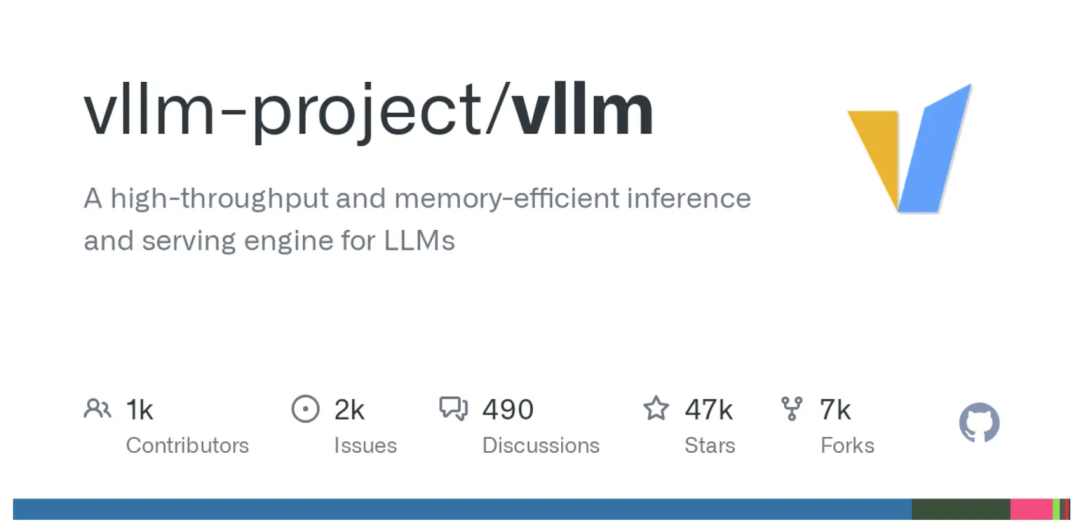

vLLM是一个专为大型语言模型(LLM)推理设计的高性能框架,通过创新的内存管理和计算加速技术,显著提升吞吐量并降低延迟,特别适用于企业级高并发场景。作为一个社区驱动的开源项目,vLLM融合了学术界与工业界的智慧,在GitHub上收获了47K Star的关注度。目前,包括腾讯在内的众多企业广泛使用vLLM进行AI模型推理,其安全性直接关系到AI服务的稳定性和数据安全。

|

||||

|

||||

|

||||

|

||||

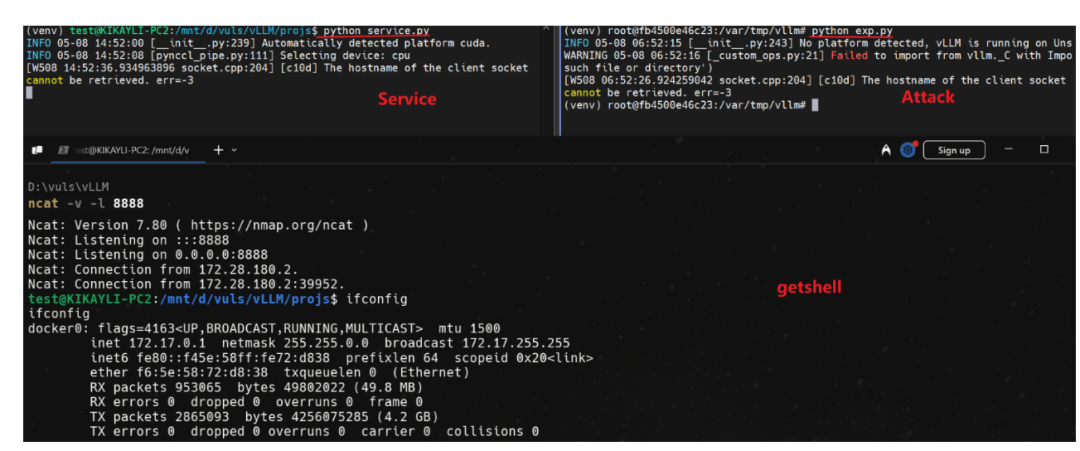

然而,vLLM的高普及度也使其成为攻击者的潜在目标。此前,vLLM曾曝光过两个位于MooncakePipe服务的严重漏洞。而本次由朱雀实验室发现的漏洞则存在于vLLM的PyNcclPipe服务中,攻击者可通过发送定制化的恶意数据包,远程获取GPU算力服务器控制权限,CVSS评分(通用漏洞评分系统,满分10分)高达9.8分。这一发现不仅揭示了新的安全风险,也为vLLM框架的漏洞研究提供了全新视角。

|

||||

|

||||

|

||||

|

||||

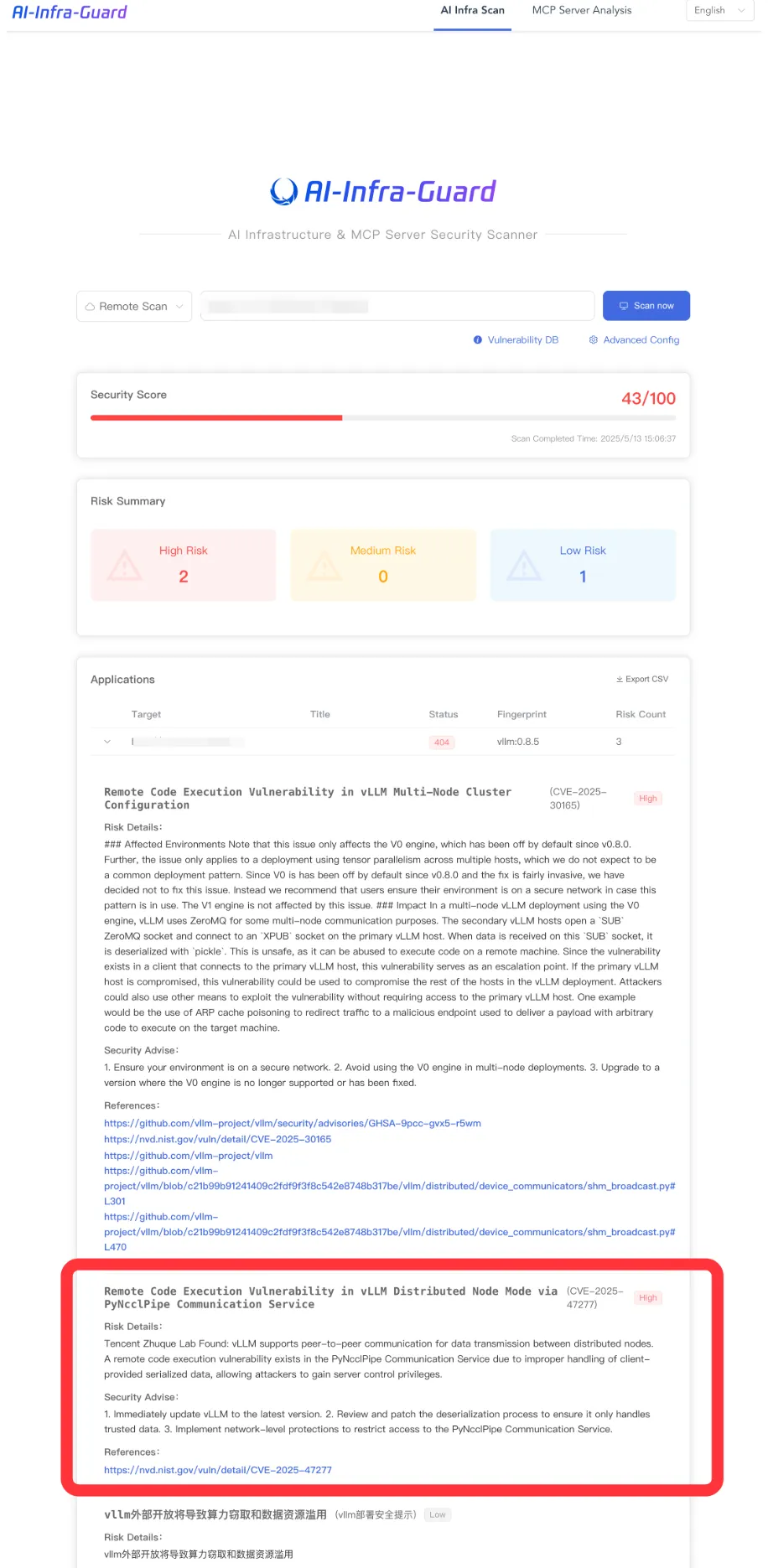

为保障混元大模型及相关AI软件供应链的安全,朱雀实验室近两年来已帮助腾讯业务提前发现与排雷了英伟达、Hugging Face和PyTorch等多个知名AI组件的严重漏洞风险,并推出了开源工具AI-Infra-Guard( https://github.com/Tencent/AI-Infra-Guard ),帮助社区与腾讯业务快速评估AI基础设施的安全风险。

|

||||

## 2. 漏洞原理与利用场景

|

||||

|

||||

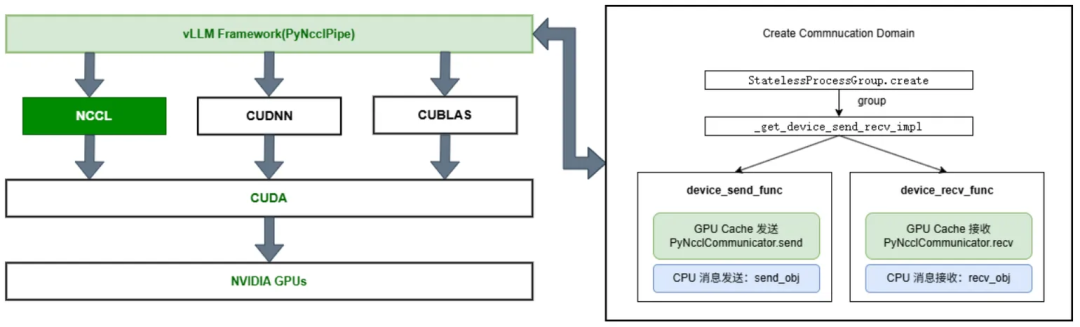

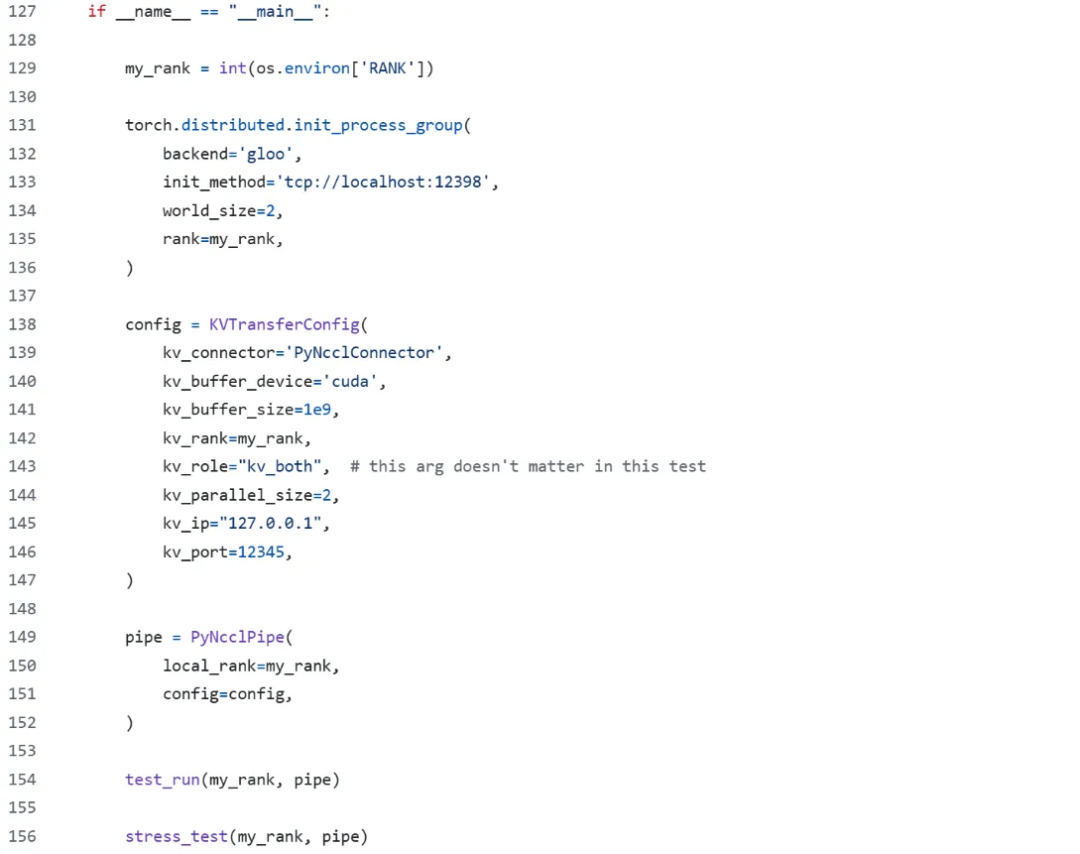

vLLM作为当前最受欢迎的推理框架之一,支持单机多卡和多机多卡推理,以降低对显卡性能的需求。在处理分布式GPU节点间的张量通信时,vLLM可选使用NVIDIA的NCCL(NVIDIA Collective Communications Library)技术。NCCL专为分布式多GPU计算环境设计,通过高效的张量集合操作实现数据通信与同步。

|

||||

|

||||

在vLLM中,PyNcclPipe类负责构建支持NCCL的通信域,实现分布式GPU节点间的高效数据传输:

|

||||

|

||||

● GPU侧:通过PyNcclCommunicator类传输KV-Cache数据;

|

||||

|

||||

● CPU侧:通过send_obj和recv_obj方法处理控制消息。

|

||||

|

||||

|

||||

|

||||

官方示例代码可参考:

|

||||

https://github.com/vllm-project/vllm/tree/main/tests/kv_transfer

|

||||

|

||||

|

||||

|

||||

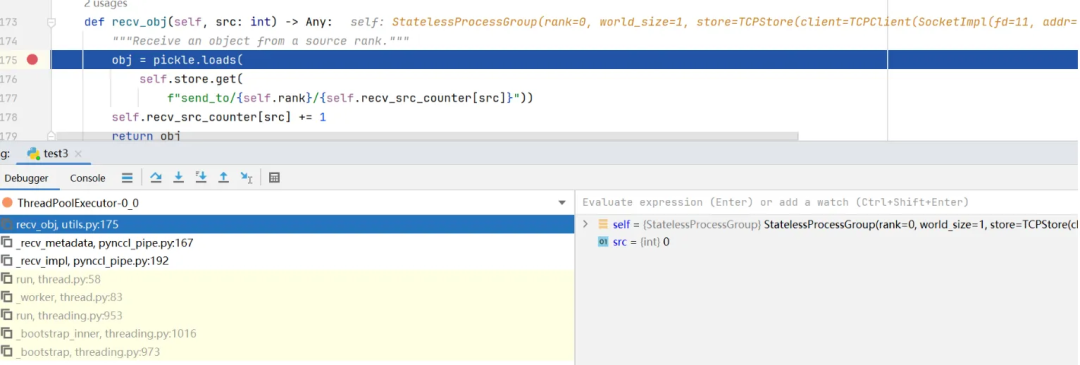

通过AI自动化代码审计结合人工验证,朱雀实验室发现,当PyNcclPipe服务接收到外部恶意客户端发来的不安全数据流时,会触发pickle反序列化漏洞,导致远程命令执行(RCE)。

|

||||

|

||||

|

||||

|

||||

攻击者可利用此漏洞控制服务器,窃取模型文件,甚至进一步渗透GPU算力集群等内网平台,造成以下严重后果:

|

||||

|

||||

● 大规模数据泄露:敏感模型和数据被窃取;

|

||||

|

||||

●

|

||||

算力窃取:攻击者占用GPU资源进行非法计算;

|

||||

|

||||

● 服务中断:AI服务不可用,影响业务连续性。

|

||||

|

||||

|

||||

|

||||

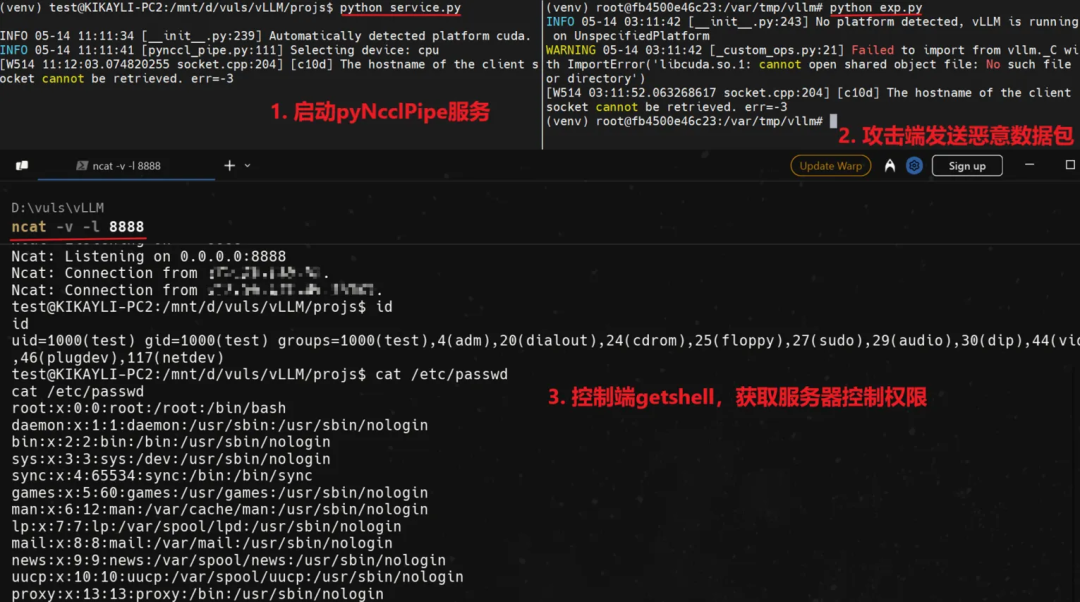

典型场景下的漏洞利用流程如下:

|

||||

|

||||

● 服务端创建PyNcclPipe服务,接受远程节点通信数据;

|

||||

|

||||

● 攻击者构造恶意数据包并发送至PyNcclPipe服务;

|

||||

|

||||

● 攻击者成功“getshell”,获取服务器控制权并实施后续攻击。

|

||||

|

||||

|

||||

## 3. 安全自查与缓解措施

|

||||

|

||||

朱雀实验室发现漏洞后,迅速向vLLM开发团队提供了详细的技术分析和复现步骤,助力团队快速定位问题。目前vLLM最新版本已修复该漏洞(版本号为0.8.5),并在邮件中致谢朱雀实验室。

|

||||

|

||||

|

||||

|

||||

为帮助vLLM社区与公司业务快

|

||||

速自查,朱雀实验室开源的AI-Infra-Guard已新增对此漏洞的扫描功能,用户可通过该工具快速评估现有vLLM组件是否受影响。若需进一步确认,可检查服务器代码是否调用了PyNcclPipe模块,并核查相关服务端口是否外部可访问。

|

||||

|

||||

|

||||

## 4. 安全建议

|

||||

|

||||

为确保vLLM在大模型推理场景的安全使用,朱雀实验室建议:

|

||||

|

||||

● 尽快更新:升级至最新版本的vLLM以修复漏洞;

|

||||

|

||||

● 容器化部署:使用容器技术隔离vLLM服务,配合网络策略限制访问;

|

||||

|

||||

● 访问控制:对外开放服务时,严格限定可信IP地址;

|

||||

|

||||

详细安全指引可参考官方文档:

|

||||

|

||||

https://docs.vllm.ai/en/latest/deployment/security.html 。

|

||||

|

||||

|

||||

## 5. 参考链接

|

||||

|

||||

|

||||

https://github.com/vllm-project/vllm

|

||||

|

||||

https://github.com/vllm-project/vllm/security/advisories/GHSA-hjq4-87xh-g4fv

|

||||

|

||||

|

||||

|

||||

|

||||

|

||||

|

||||

Loading…

x

Reference in New Issue

Block a user